Создание Android приложения для обнаружения лиц в режиме реального времени с использованием Firebase ML Kit

Содержание

-

1 Создание Android приложения для обнаружения лиц в режиме реального времени с использованием Firebase ML Kit

- 1.1 Создание Android приложения для обнаружения лиц в режиме реального времени с использованием Firebase ML Kit

- 1.2 Что такое Firebase ML Kit и как это работает

- 1.3 2. Настройка проекта Android Studio

- 1.4 Creating a real-time face detection application in 3 steps

- 1.5 Детектор лиц (Face Detector)

- 1.6 Что внутри? Кратко об основных отчетах Firebase Analytics

Создание Android приложения для обнаружения лиц в режиме реального времени с использованием Firebase ML Kit

Wed, 12 Feb 2020 14:49:00 +0000

Все модели машинного обучения за 6 минут

[https://nuancesprog.ru/p/6621/]

Подробное руководство по свёрточным нейронным сетям

[https://nuancesprog.ru/p/8307/]

Глубокие свёрточные нейросети: руководство для начинающих

[https://nuancesprog.ru/p/8802/]

DetectoRS — новейшее средство обнаружения объектов от Google Research

[https://nuancesprog.ru/p/9477/]

AR VR

Google launches impressive single camera ARCore depth sensing with Snapchat, Samsung

[https://9to5google.com/2020/06/25/android-arcore-depth/]

Facebook показала прототип плоских VR-очков с голографическим экраном

[https://nplus1.ru/news/2020/06/30/facebook-vr]

[https://t.me/android_broadcast/1915]

В посте (https://android-developers.googleblog.com/2020/06/mlkit-on-device-machine-learning-solutions.html) рассказывается про то, что:

для использования ML Kit проект в Firebase больше не обязателен

для использования ML Kit проект в Firebase больше не обязателен

ML Kit обрабатывает данные в режиме реального времени, без задержек из-за сетевых запросов

ML Kit обрабатывает данные в режиме реального времени, без задержек из-за сетевых запросов

работает в offline режиме

работает в offline режиме

пользовательские данные не отправляются в сеть, а значит приватность сохраняется

пользовательские данные не отправляются в сеть, а значит приватность сохраняется

некоторые модели доставляются через Google Play Services, а значит уменьшается размер приложения при установке

некоторые модели доставляются через Google Play Services, а значит уменьшается размер приложения при установке

можно использовать не только готовые модели, но и собственные модели TensorFlow Lite

можно использовать не только готовые модели, но и собственные модели TensorFlow Lite

в рамках программы раннего доступа можно ознакомиться с новыми моделями: Entity Extraction и Pose Detection

в рамках программы раннего доступа можно ознакомиться с новыми моделями: Entity Extraction и Pose Detection

добавлена поддержка Android Jetpack Lifecycle (https://developer.android.com/reference/androidx/lifecycle/Lifecycle), что облегчает остановку использования ML Kit на основании жизненного цикла

добавлена поддержка Android Jetpack Lifecycle (https://developer.android.com/reference/androidx/lifecycle/Lifecycle), что облегчает остановку использования ML Kit на основании жизненного цикла

интеграция с Lifecycle также сделала использование CameraX (https://developer.android.com/training/camerax) проще и удобнее.

интеграция с Lifecycle также сделала использование CameraX (https://developer.android.com/training/camerax) проще и удобнее.

Как начать работать с новым ML Kit и его поддержкой CameraX можно узнать в code lab Recognize, Identify Language and Translate text (https://codelabs.developers.google.com/codelabs/mlkit-android-translate/)

Как начать работать с новым ML Kit и его поддержкой CameraX можно узнать в code lab Recognize, Identify Language and Translate text (https://codelabs.developers.google.com/codelabs/mlkit-android-translate/)

FrankMocap: A Strong and Easy-to-use Single View 3D Hand+Body Pose Estimator

[https://github.com/facebookresearch/frankmocap]

TensorFlow

Detection

Сканер документов на основе технологии машинного зрения

[https://nuancesprog.ru/p/7590/]

http://www.arvifox.com/2020/02/12/vr-ar-ml-etc/feed/ 0 Google Cloud AR Computer Vision

http://www.arvifox.com/2020/01/09/google-mobile-vision/ http://www.arvifox.com/2020/01/09/google-mobile-vision/#respond

Thu, 09 Jan 2020 13:01:00 +0000

News

Google Search AR starts rolling out depth-based object blending/occlusion [https://9to5google.com/2019/12/23/google-search-ar-object-blending/]

Самый мягкий и пушистый путь в Machine Learning и Deep Neural Networks [https://habr.com/ru/company/avito/blog/470904/]

Google shows off stunning new AR features coming to web and mobile apps soon 19

Part of a ARCore’s new Depth API in the works [https://www.theverge.com/2019/12/9/20999646/google-arcore-augmented-reality-updates-occlusion-physics-depth]

Introducing the ARCore Depth API for Android and Unity

[https://youtu.be/cLQJ864LNWI]

Is there a way to draw a Line between two anchors using Sceneform [https://github.com/google-ar/sceneform-android-sdk/issues/200]

Change Texture of SelectionVisualizer for Selected TransformableNodes [https://github.com/google-ar/sceneform-android-sdk/issues/106]

How ARKit and ARCore recognize vertical planes despite limited depth perception [https://blog.griddynamics.com/how-arkit-and-arcore-recognize-vertical-planes/]

Best AR SDK for development for iOS and Android in 2018 [https://thinkmobiles.com/blog/best-ar-sdk-review/]

Building a real-time face detector in Android with ML Kit [https://heartbeat.fritz.ai/building-a-real-time-face-detector-in-android-with-ml-kit-f930eb7b36d9] Создание Android приложения для обнаружения лиц в режиме реального времени с использованием Firebase ML Kit [https://habr.com/post/421869/]

Google Identity Platform

ML Kit

Mobile Vision

The Mobile Vision API is now a part of ML Kit. We strongly encourage you to try it out, as it comes with new capabilities like on-device image labeling! Also, note that we ultimately plan to wind down the Mobile Vision API, with all new on-device ML capabilities released via ML Kit. Feel free to reach out to Firebase support for help.

Single/multi view image(s) to voxel reconstruction using a recurrent neural network [https://github.com/chrischoy/3D-R2N2/]

Visual Positioning Service

Tango is also one of the core technologies behind our new Visual Positioning Service ( VPS ), which helps devices quickly and accurately understand their location indoors. While GPS is great for getting you to the storefront, with VPS your device can direct you right to the item you’re looking for once inside. VPS works today in partner museums and select Lowe’s stores. We think VPS will be powerful in a variety of scenarios. For instance, imagine how precise location enabled by VPS, combined with audio interfaces, could help visually-impaired people navigate through the world.

Vuforia’s latest object recognition technology

Wikitude Cloud Recognition

Face recognition / face tracking

Theory and algorithms

-

- https://elibrary.ru/item.asp?id=27711306

Основная идея распознавания лица состоит в выделении информативных признаков в изображении лица, кодировании этого изображения и сравнении его с информацией, хранящейся в базе данных. В данной работе проводится анализ алгоритмов, базирующихся на методе главных компонент, линейном дискриминантном анализе, обнаружении локальных признаков, с применением вейвлетов Габора, дискретном косинусном преобразовании, локальных бинарных шаблонах. Отмечается, что для корреляционных методов характерна вычислительная сложность и требуются большие объемы памяти, в этой связи на практике целесообразным является применение соответствующих методов, позволяющих уменьшить размерность признаков. Указаны последние разработки компании “Вокорд”, базирующиеся на использовании глубоких нейронных сетей, использующих тестовую базу с миллионом фотографий.

- https://elibrary.ru/item.asp?id=27711306

-

- метод Виолы-Джонса – первое по сути мощное решение

- Алгоритм Далала-Триггса

- https://findface.pro/en/ by NtechLab based on neural network. One of the best solutions.

- http://www.yitutech.com/en/

Facial recognition, vehicle identification, text recognition, target tracking

- https://tevian.ru/product/facesdk

- Идентификация лица – метод главных компонент, позже сверточные нейронные сети

- https://habr.com/company/synesis/blog/238129/ Анализ существующих подходов к распознаванию лиц

- http://algowiki-project.org/ru/%D0%A0%D0%B0%D1%81%D0%BF%D0%BE%D0%B7%D0%BD%D0%B0%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5_%D0%BB%D0%B8%D1%86

- http://wiki.technicalvision.ru/index.php/%D0%92%D1%8B%D0%B4%D0%B5%D0%BB%D0%B5%D0%BD%D0%B8%D0%B5_%D0%B8_%D1%80%D0%B0%D1%81%D0%BF%D0%BE%D0%B7%D0%BD%D0%B0%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5_%D0%BB%D0%B8%D1%86

Change hair color

Augmented Images – Video on Wall in ARCore 1.2 Tutorial

OBJECT RECOGNITION WITH VUFORIA

80+ лучших инструментов для разработчиков VR и AR [ https://dev.by/news/80-vr-ar ]

Demonstrates usage of the Speech SDK to manage voice communication with your Bot-Framework bot, registered with Direct Line Speech channel [ https://github.com/Azure-Samples/Cognitive-Services-Direct-Line-Speech-Client ]

Лучшие бесплатные источники наборов данных для анализа [ https://nuancesprog.ru/p/4258/ ]

Fri, 17 May 2019 17:08:25 +0000

Руководство по машинному обучению для новичков [ https://nuancesprog.ru/p/3489/ ]

Плотность вероятности — это не сама вероятность [ https://nuancesprog.ru/p/5036/ ]

Условная независимость — основа байесовской сети [ https://nuancesprog.ru/p/5511/ ]

Сумма экспоненциальных случайных величин [ https://nuancesprog.ru/p/4966/ ]

NVIDIA 3D модель

Learning to Predict 3D Objects with an Interpolation-based Differentiable Renderer (NeurIPS 2019) [ https://github.com/nv-tlabs/DIB-R ]

Learning to Predict 3D Objects with an

Interpolation-based Differentiable Renderer

Learning to Predict 3D Objects with an Interpolation-based Differentiable Renderer

Sat, 18 Aug 2018 12:22:51 +0000

http://www.arvifox.com/?p=3431 In Google Play:

-

- 3D Scanner for ARcore (Lubos Vanesek) – beta

-

- SCANN3D – photogrammetry technology (PGT)

-

- Voxxlr – google play – uses Tango, process on Voxxlr’s cloud platform

-

- Scandy Pro – google play – needs depth sensor or Tango phones – uses Tango

-

- Trnio – photo capture on iPhone

- Scann3D – photo capture on Android, process on Android

-

- Structure sensor 3D scanner

- Qlone – a user have to print out the Qlone mat.

-

5 Best 3D Scanner Apps (For Your Smartphone)

-

- How to 3D scan with a smartphone

-

- The 7 best 3D scanning apps for smartphones

-

- Cappasity – not yet released

- 3DUniversum – youtube demo – Structure Sensor, Google Tango and Intel RealSense

Intel RealSense

Intel RealSense — теперь и в смартфоне

cuDNN

Библиотека cuDNN для быстрого обучения нейронных сетей на GPU.

cuDNN is supported on Windows, Linux and MacOS systems with Volta, Pascal, Kepler, Maxwell Tegra K1, Tegra X1 and Tegra X2 GPU s.

http://www.arvifox.com/2018/08/18/3d-scanner-android/feed/ 0 ML Kit: Machine Learning SDK for mobile developers (Google I/O ’18)

http://www.arvifox.com/2018/04/13/ml-kit-machine-learning-sdk-for-mobile-developers-google-i-o-18/ http://www.arvifox.com/2018/04/13/ml-kit-machine-learning-sdk-for-mobile-developers-google-i-o-18/#respond

Fri, 13 Apr 2018 09:57:27 +0000

Что такое Firebase ML Kit и как это работает

ML Kit — это SDK, предоставляющая возможность использовать уже готовые решения machine learning от Google для iOS и Android в простом виде. Независимо от того, есть ли у вас опыт использования machine learning, вы можете реализовывать нужные вам функции в нескольких строках кода. Если же вы являетесь опытным разработчиком в сфере машинного обучения, то вы можете загрузить собственные модели TensorFlow.

ML Kit может работать как в режиме онлайн (при этом вы получаете ,свободный доступ к гораздо более солидной базе данных, но с ограничением по запросам: бесплатно лишь первая тысяча), так и оффлайн. Такие функции, как распознавание текста, штрих-кодов и образов, доступны как онлайн, так и оффлайн. Распознавание ориентиров (известные дома, реки, улицы и т.д.) доступно только в режиме онлайн, а распознавание лиц — только оффлайн на устройстве.

2. Настройка проекта Android Studio

Прежде чем вы начнете использовать API Firebase ML Kit, вы должны установить соединение между вашим проектом Android Studio и проектом Firebase, созданным на предыдущем шаге. Для этого откройте панель Firebase Assistant, перейдя в меню Инструменты> Firebase.

У Firebase Assistant в настоящее время нет поддержки ML Kit. Тем не менее, используя его для добавления Firebase Analytics, вы все равно можете не устанавливать соединение вручную. Поэтому разверните раздел Аналитика, нажмите ссылку Добавить событие Analytics и нажмите кнопку Подключиться к Firebase.

В появившемся диалоговом окне убедитесь, что вы выбрали опцию Выбрать существующий Firebase или Google проект и выберите проект, который вы создали.

Нажмите кнопку Подключиться к Firebase. На этом этапе помощник автоматически загрузит файл google-services.json, содержащий ключи API и идентификаторы проектов, и добавит его в модуль app .

После того, как соединение будет успешно установлено, убедитесь, что вы нажали кнопку Добавить Google Analytics в ваше приложение, чтобы добавить различные базовые зависимости Firebase к файлу build.gradle вашего модуля app .

Затем, чтобы добавить библиотеку ML Kit, откройте файл build.gradle и введите следующие реализации implementation :

Чтобы упростить процесс загрузки изображений из Интернета и отображения их в приложении, я предлагаю вам также добавить зависимость для библиотеки Picasso.

Кроме того, добавьте Anko в качестве зависимости, чтобы убедиться, что код Kotlin является кратким и интуитивным.

По умолчанию локальные модели Firebase ML Kit автоматически загружаются на устройства пользователя только по мере необходимости. Однако, если вы хотите, чтобы они были загружены сразу после установки вашего приложения, добавьте следующий код в файл AndroidManifest.xml:

Чем отличается Android Go от обычного Android

Android Go — How does Google’s lightweight ecosystem compare to the original? — статья с описанием отличий облегченной версии Android от полноценной. Основные тезисы:

- В отличие от устройств Android One, которые поставляются на рынок с «чистым Android», смартфоны на Android Go будут продаваться с модификациями и приложениями производителя смартфона (если он этого пожелает).

- Единственное заметное пользователю отличие Android Go от обычного Android — дизайн окна запущенных приложений.

- В Android Go отключены некоторые ненужные большинству пользователей функции: Daydream VR, функция разделения экрана, поддержка Android Auto и Android Wear, Android for Work.

- По умолчанию в Android Go отключено шифрование, однако некоторые устройства позволят его включить.

- Android Go гораздо более агрессивен в уничтожении фоновых приложений (он старается убрать из памяти все, что не связано с самой операционной системой).

- В Android Go по умолчанию включен zRAM, сжимающий данные в оперативной памяти для ее экономии.

- Некоторые предустановленные приложения Android Go — это веб-приложения; например, Gmail Go и Google Maps Go -—это WebView, в котором открывается написанный на HTML5/JS интерфейс, причем Google Maps Go весит 1 Мбайт, а Gmail Go больше стандартного приложения Gmail.

- Часть приложений из комплекта Android Go сильно урезаны: YouTube Go не поддерживает комментарии и не позволяет ставить лайки, Assistant Go не имеет каких-либо опций, другие, наоборот, предоставляют полный набор функций: Google Maps Go почти в точности повторяет оригинальное приложение.

|

|

| Gmail Go и Google Maps Go | |

Новые защитные функции Android P

Compiler-based security mitigations in Android P — пост разработчиков Android с рассказом о том, какие функции компилятора LLVM/Clang они применили в Android P для защиты от разного вида атак.

- Control Flow Integrity. В современных эксплоитах важным шагом часто бывает модификация указателей на функцию и адресов возврата. Она позволяет обойти ограничение на исполнение стека и сегмента данных с помощью переиспользования кусков самого приложения.

Технология Control Flow Integrity (CFI) предназначена для борьбы с такими эксплоитами. При ее включении компилятор строит граф вызовов функций и встраивает код сверки с этим графом перед каждым вызовом функции. Если вызов происходит по отклоняющемуся от графа адресу, приложение завершается.

Разработчики Android уже включили CFI для нескольких системных компонентов в Android 8. В Android P покрытие расширилось и теперь включает в себя медиафреймворки, а также стек NFC и Bluetooth. Тестовая поддержка также реализована для ядра.

- Integer Overflow Sanitization. Данная технология предназначена для защиты от целочисленного переполнения. Компилятор встраивает в результирующий код приложений функции проверки, которые используются для подтверждения, что исполняемая арифметическая операция не вызовет переполнения.

Впервые технология была использована в Android 7 для защиты медиастека, в котором обнаружили целый комплекс удаленных уязвимостей Stagefright. В Android P она также используется для защиты следующих компонентов: libui, libnl, libmediaplayerservice, libexif, libdrmclearkeyplugin и libreverbwrapper.

Код вызова функции с отключенным и включенным CFI

Код вызова функции с отключенным и включенным CFI

Обратный TCP-шелл с помощью Frida

Shellcoding an Arm64 In-Memory Reverse TCP Shell with Frida — статья с рассказом, как внедрить в Android обратный TCP-шелл с помощью Frida.

Это возможно благодаря классу Arm64Writer, который появился во Frida 10.4. Он позволяет записывать инструкции ARM64 прямо в память, а затем исполнять их. Чтобы создать обратный шелл, автор статьи написал его на языке ассемблера, а затем с помощью Arm64Write поместил в память процесса system_server (в Android это один из центральных компонентов операционной системы).

Часть кода обратного шелла:

Creating a real-time face detection application in 3 steps

Using the face detection library (which contains the code described above), creating an application becomes quite simple.

In this example, I selected the following camera library .

Step 1. Add FaceBoundsOverlay on top of the camera.

Step 2. Identify the instance FaceDetection and connect it to the camera.

Step 3. Configure Firebase in the project.

Мы рисуем на Canvas, а значит, анимацию нужно реализовывать самим. Если есть картинки с анимацией, запрограммировать это будет легко. Вводим класс для объекта со сменяющимися изображениями.

Чтобы получился эффект движения, фон тоже должен быть анимированным. Иметь серию кадров фона в памяти — накладная история. Поэтому поступим хитрее: одно изображение будем рисовать со сдвигом по времени. Схема идеи:

Полный diff шага.

Сложно назвать это шедевром, но для прототипа за вечер сойдёт. Код можно найти тут. Запускается локально без дополнительных махинаций.

В заключение добавлю, что ML Kit Face Detection может пригодиться и для других сценариев.

Например, чтобы делать идеальные селфи с друзьями: можно анализировать всех людей в кадре и убеждаться, что все улыбнулись и открыли глаза. Определение нескольких лиц в видеопотоке работает из коробки, поэтому задача несложная.

Используя распознавание контуров лица из модуля Face Detection, реально повторить маски, которые сейчас популярны почти во всех приложениях с камерой. А если добавить интерактив — через определение улыбки и подмигивания, — то пользоваться ими будет вдвойне весело.

Эту функциональность — определение контуров лица — можно применять не только для развлечений. Те, кто сами пытались вырезать фото на документы, оценят. Берём контур лица, автоматически вырезаем фото с нужным соотношением сторон и правильным положением головы. Определить правильный угол съёмки поможет датчик гироскопа.

Детектор лиц (Face Detector)

Детектор лиц является самым важным компонентом — он берёт кадр, обрабатывает его и затем выводит результаты пользователю. Таким образом, детектор лиц использует экземпляр FirebaseVisionFaceDetector для обработки входящих кадров с камеры. Он также должен знать ориентацию камеры и её направление (передняя или задняя). Наконец, он должен знать на каком оверлее будут отображаться результаты. Скелет класса FaceDetector выглядит так:

Рекламодатели, запуская мобильные рекламные кампании по стандартным моделям, зачастую сталкиваются со следующими трудностями:

- Модель CPC (цена за клик): нет возможности выкупать трафик дороже установленного CPC. Необходимо определять и устанавливать ставки для разных площадок. Это усложняет работу, банально, требуется каждый раз считать конверсии с разными названиями кампаний.

- Модель CPA/CPO (оплата за действие): сложно прогнозировать объем и ставку до начала кампании, требует запуска теста, медленно масштабируется и, как следствие, не всегда получается спрогнозировать бюджет.

Есть и плюсы, например по CPC можно очень быстро масштабировать рекламные кампании, а работая по CPA/CPO, меньше рисков для клиента в том, что трафик не окупится.

Мы хотели найти некий баланс, который позволил бы нам лучше прогнозировать результат с меньшими рисками для клиента. Так появилась идея новой модели на рынке мобильного ретаргетинга: CPE — аналога CPI в User Acquisition.

Что такое CPE?

CPE — это модель оплаты за вовлеченного пользователя. По сути, оплата производится за пользователей, которые перешли в мобильное приложение при взаимодействии с рекламой. Эта модель позволяет рекламодателям более эффективно возвращать пользователей, которые уже установили мобильное приложение на свой смартфон.

Количество оплачиваемых пользователей рассчитывается не как число кликов, но как число реатрибуций — конверсий reattribution / re-engagement в популярных трекинговых системах (Adjust, AppsFlyer и других).

Особенности CPE модели

Данная модель находится ступенью выше в воронке: CPC > CPE > CPA > CPO. В отличие от CPC, оплачиваться будут только клики, которые привели к открытию приложения. Также для запуска по CPA или CPO требуется время для построения когорт и оценки сроков окупаемости трафика, а CPE позволяет быстро масштабироваться. Но при этом, риски, что трафик не окупится, остаются.

Удобство CPE модели в том, что она более универсальна, так как позволяет запустить ретаргетинг сразу на нескольких площадках по одним и тем же условиям, а также быстро масштабироваться. Пример для наглядности: стоимость трафика дороже на MyTarget и Facebook, а конверсия выше; RTB трафик в среднем дешевле, но конверсия ниже. Таким образом, стоимость CPE не будет зависеть от площадки, а будет зависеть от аудитории. Стоит отметить, что на RTB инвентаре, как правило, более дорогие площадки дают более высокую конверсию.

Проблемы мобильного ретаргетинга и решение в виде CPE модели

Идеальная картина в ретаргетинге — когда все пользователи переходят на конечную страницу или в приложение. Применимо к мобильному ретаргетингу: когда конверсия из кликов в реатрибуции близится к 100%. Но на практике мы не так часто видим такую конверсию. Этому есть несколько причин:

- Пользователь мог удалить приложение и его редиректит в стор. Чем с более давней аудиторией мы работаем, тем больше пользователей, которые удалили приложение, тем меньше конверсия.

- Рекламное объявление не всегда рендерится правильным образом, и пользователя редиректит в стор. Так, конверсия будет высокой на Facebook или MyTarget, а на RTB инвентаре будет ниже. Прежде всего, это происходит из-за того, что технологии deeplinks, universal links, app links достаточно новые и часто меняются, не все успевают адаптироваться к изменениям.

- Еще одна вытекающая проблема: не всегда правильно срабатывает трекинг существующих систем аналитики. Часто возникают трудности при интеграции deeplinks или universal links с используемым трекингом. Т.е. даже если пользователь перешел в приложение, конверсия может быть не засчитана.

При запуске по CPE, проблемы типа кривой настройки deeplinks или universal link видны сразу. Партнер же первый, кто заинтересован эти проблемы решить, как следствие запуск возможен, когда все работает правильно. Это позволит обеспечить более качественный UX ретаргетинговых кампаний, основной показателя которого — это конверсия в открытие приложения.

Резюмируя плюсы CPE модели:

- Эффективный расход бюджета: оплата только за реально вернувшихся пользователей;

- Можно быстро масштабировать рекламную кампанию;

- Модель универсальна, можно начать работу сразу на нескольких источниках;

- Качественный UX: кликая на рекламу, пользователь перенаправляется на нужный экран в приложении;

- Прозрачность: каждое событие реатрибуции отражено в трекере клиента;

- Целевой таргетинг: можно покупать пользователей дороже установленной цены за клик.

Минусы CPE модели:

- Есть риски, что трафик не окупится;

- Требуются ресурсы для настройки ссылок и трекинга;

- Необходимо устанавливать разные ставки для разных аудиторий.

Если вам подходит CPE модель, и вы давно хотели попробовать, как работает мобильный ретаргетинг — обращайтесь к команде Getloyal! За два года работы мы успели запустить ретаргетинг для 30 разных категорий мобильных приложений.

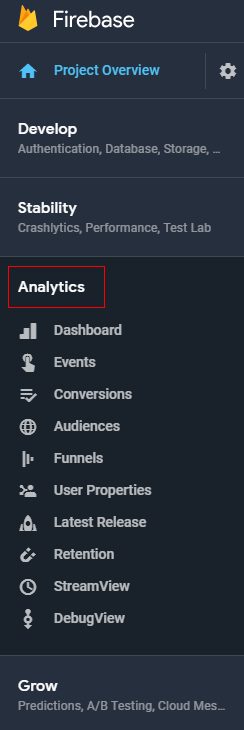

Что внутри? Кратко об основных отчетах Firebase Analytics

Firebase Analytics можно найти в консоли Firebase наравне с пунктами Develop, Stability, Grow:

На основной вкладке Dashboard (Сводка) нам доступны ключевые отчеты по умолчанию:

Активные пользователи. Количество активных пользователей за выбранный диапазон дат (30 дней, 7 дней или 1 день) с учетом изменений в процентах по отношению к предыдущему диапазону дат. Активный пользователь — это человек, который взаимодействовал с приложением, когда оно было активно на устройстве, и это взаимодействие привело к регистрации события user_engagement.

Как часто пользователи совершают конверсии. На этом отчете отображен график наиболее важных событий-конверсий относительно шкалы времени (30 дней по умолчанию).

С чем взаимодействуют ваши пользователи. Речь о наиболее популярных экранах приложения, на которых люди бывают чаще (в процентах от всех экранов) и на каких экранах пользователи проводят больше всего времени.

Какой доход вы получаете от приложения. Общее значение поступлений от всех источников дохода с учетом заданной ценности событий-конверсий (стоимость покупки). Также этот отчет включает расчетный доход от AdMob — инструмента от Google, который позволяет разработчикам получать прибыль от своих мобильных приложений.

Насколько стабильно работает ваше приложение. Демонстрирует процент пользователей, у которых не было сбоев в приложении (для всех версий приложения).

Нравится ли пользователям последняя версия приложения. Здесь анализируется последний билд приложения в разрезе таких показателей, как процент активных пользователей и процент пользователей, у которых возникали (или нет) сбои. На основании отчета формируется статус успешности/проблемности последнего билда приложения.

Как вы привлекаете новых пользователей. Отчет об источниках трафика, которые атрибутируются по первому открытию пользователем приложения (событие first_open).

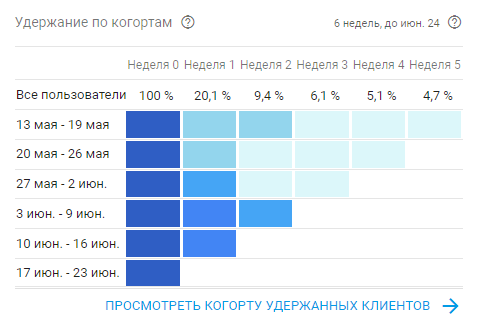

Насколько эффективно вы удерживаете пользователей. Когорты по удержанию приложением (Retention Rate). Например, из когорты на скрине видно, что на второй неделе приложением пользуются 20% пользователей, а на пятой 4,7% пользователей. Довольно скромный результат.

К слову, показатель Retention Rate не всегда является индикатором качества привлеченного трафика.

Кроме вкладки Dashboard (Сводки) в Firebase Analytics доступны такие ключевые разделы:

Несколько слов о каждом:

События — таблица с названиями, количеством всех уникальных событий (по пользователям). Здесь можно менять диапазон дат на произвольный и скачивать информацию в формате CSV файла.

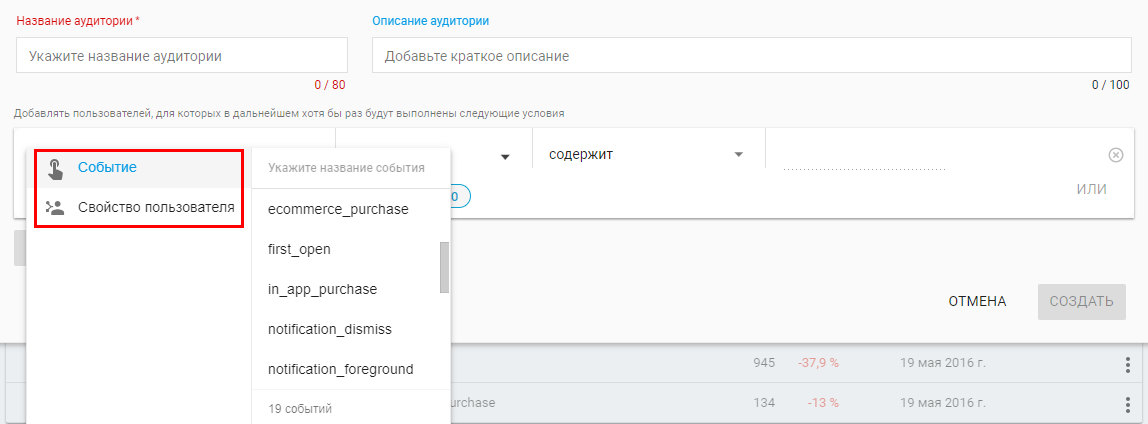

Аудитории — на вкладке можно создать аудиторию на основании совпадения определенных условий по событиям и свойствам пользователей:

Примеры аудиторий: пользователи, которые платят (по событиям); все пользователи новой версии приложения на Android (по свойству пользователя); VIP пользователи — пользователи iOS, которые совершили три или более покупки и у которых iPhone с новейшей версией ОС (одновременно по событию и свойству пользователей).

Атрибуция — в разделе данные о том, сколько в Firebase зарегистрировано событий-конверсий, связанных с определенными источниками трафика и рекламными сетями.

Последовательности позволяют визуализировать и, в перспективе, увеличить процент выполнения операций, состоящих из нескольких шагов (событий) в приложении за счет поиска и устранения узких мест. Например, это может быть последовательность микро конверсий, которые должен выполнить пользователь для совершения финальной конверсии.

Когорты — группа пользователей, которые одновременно работали с вашим приложением, например в один день или в течение недели. По этому отчету можно судить, насколько лояльны пользователи к приложению.

Streamview помогает разобраться, как приложение используется в обычных ситуациях — получить набор актуальных тенденций пользования. Данные можно просматривать в режиме реального времени. Это позволяет выявить тенденции, которые еще только намечаются.

Свойства пользователей. Параметры событий, которые автоматически регистрируются при каждом вызове logEvent. После настройки свойств пользователя вы сможете фильтровать по ним данные в отчетах. Например, узнать, как отличается поведение людей, которые покупают, от поведения тех, кто этого не делает.